Fallet med Melissa Sims visade hur farligt okontrollerat AI-innehåll kan vara i rättssystemet. Branschen utlovar ett botemedel i form av så kallade "AI-detektorer", programvara som är avsedd att använda komplexa algoritmer för att känna igen om en bild kommer från en människa eller en maskin. Tillförlitligheten hos dessa digitala vakthundar är dock fortfarande tveksam när de ställs inför avsiktligt bedrägeri. Ett experiment med sex av de för närvarande vanligaste detekteringstjänsterna satte detta på prov.

Testbilden: En surrealistisk utmaning

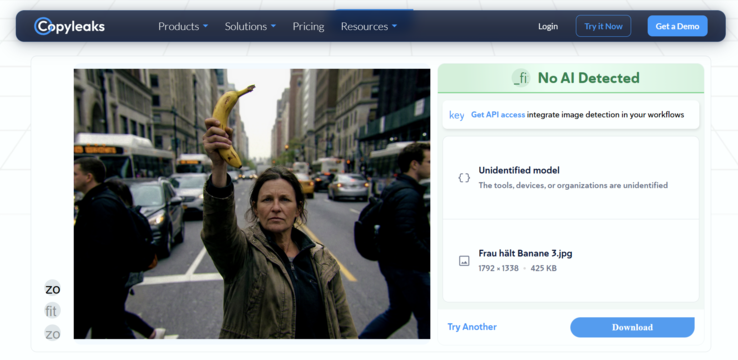

För att utmana detekteringsverktygen använde vi den Google Gemini-baserade bildgeneratorn "Nano Banana Pro" Den valda prompten var avsiktligt enkel men ändå lite nyckfull: "En kvinna som intar en stridsposition och håller en banan mot himlen. Bakgrund typisk stadsbild med ointresserade människor."

Det första stora hindret för den automatiska detekteringsprogramvaran har dock sitt ursprung i den specifika modell som används. Eftersom Nano Banana Pro är relativt ny på marknaden utgör den en blind fläck för många detektorer.

Dessa tjänster bygger ofta på maskininlärning och är särskilt utbildade för att identifiera de unika signaturerna eller "fingeravtrycken" hos etablerade giganter som Midjourney, DALL-E 3, Stable Diffusion eller Flux. Följaktligen har en ny modell som Nano Banana Pro en tydlig fördel, eftersom dess specifika generationsmönster ännu inte är en del av detektorernas träningsdata, vilket gör att den lättare kan glida igenom sprickorna.

Topp 10...

» Topp 10: Bästa bärbara allround/multimediadatorerna

» Topp 10: Bästa bärbara speldatorerna

» Topp 10: Bärbara budget/kontorsdatorer

» Topp 10: Bästa bärbara kontors/premiumdatorerna

» Topp 10: Bärbara arbetsstationer

» Topp 10: De bästa små/kompakta bärbara datorerna

» Topp 10: Bästa ultrabooks

» Topp 10: Bästa hybriddatorerna

» Topp 10: Bästa surfplattorna

» Topp 10: Marknadens bästa smartphones

Omgång 1: Misslyckande trots vattenstämplar

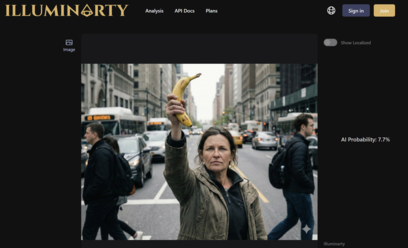

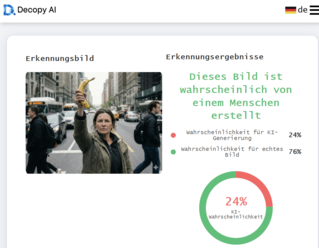

I det första steget ställdes detektorerna inför en enkel uppgift. Den ursprungliga PNG-bilden konverterades helt enkelt till ett JPG-format och dess metadata eliminerades. Avgörande var att bilden fortfarande innehöll en tydligt synlig Gemini vattenstämpel.

Man skulle kunna tro att ett synligt AI-märke skulle vara en lätt match för detekteringsprogram. Resultatet var dock nyktert: även i detta råa tillstånd misslyckades två av de sex testade verktygen. Trots den uppenbara vattenstämpeln klassificerade de sannolikheten för att bilden skulle vara AI-genererad som låg.

Omgång 2: Det digitala suddgummit

I det andra steget närmade vi oss ett realistiskt förfalskningsscenario. Den identifierande vattenstämpeln var tvungen att försvinna. På bara några sekunder slutförde det inbyggda AI-gummit i standardprogrammet Windows Photos jobbet utan problem.

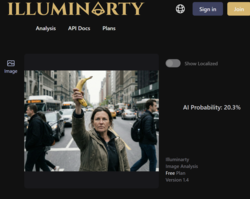

Effekten av denna mindre redigering var omedelbar. Ett annat verktyg blev lurat och klassificerade nu AI-sannolikheten som låg. Intressant nog ökade dock Illuminarty faktiskt sin sannolikhetsklassificering för en AI-genererad bild efter redigeringen. Trots detta bedömde tre av de sex AI-detekteringsverktygen att sannolikheten var mindre än 30 % för att kvinnan med bananen var en AI-skapelse.

Omgång 3: Perfektion i det ofullkomliga

Det sista steget var avgörande. AI-bilder är ofta "för släta" och för perfekta i sin brist på brus. För att slutligen vilseleda detektorerna behövde bilden artificiell "verklighet", vilket innebär typiska fel i digital fotografering. Med hjälp av Cyberlink PhotoDirector efterbehandlades bilden. En lätt linskorrigering lades till, artificiell kromatisk aberration skapade färgmarginaler vid kanterna, kontrasten ökades och, viktigast av allt, realistiskt bildbrus lades över landskapet. Målet var att få bilden att se ut som en tagning från en riktig, ofullkomlig kamera. Allt detta gjordes inom loppet av några minuter.

Originalbild och bearbetad bild i jämförelse

Resultatet av denna tredje omgång var ett totalt nederlag för detekteringstekniken. Efter att bilden hade gått igenom denna standardiserade efterbehandling gav alla sex testade tjänster upp. Inte ett enda verktyg visade en AI-sannolikhet på mer än 5 procent. För programvaran var kvinnan som slår en banan nu utan tvekan ett riktigt foto.

Dom: En farlig känsla av säkerhet

Vårt experiment visar tydligt att de nuvarande tekniska lösningarna för AI-detektering fortfarande är i sin linda. Om det bara tar några minuter och ett vanligt fotoredigeringsprogram att sänka upptäcktsgraden från "mycket sannolikt" till "under 5 procent" är dessa verktyg för närvarande inte bara värdelösa för domstolar, nyhetsredaktioner eller brottsbekämpning - de är farliga. De skapar en falsk känsla av säkerhet som helt enkelt inte existerar. Principen "lita på, men verifiera" fungerar bara om verifierarna inte är blinda.