Samsung levererar det dyraste AI-minnet som Nvidia någonsin beställt när HBM4 överträffar viktiga specifikationer

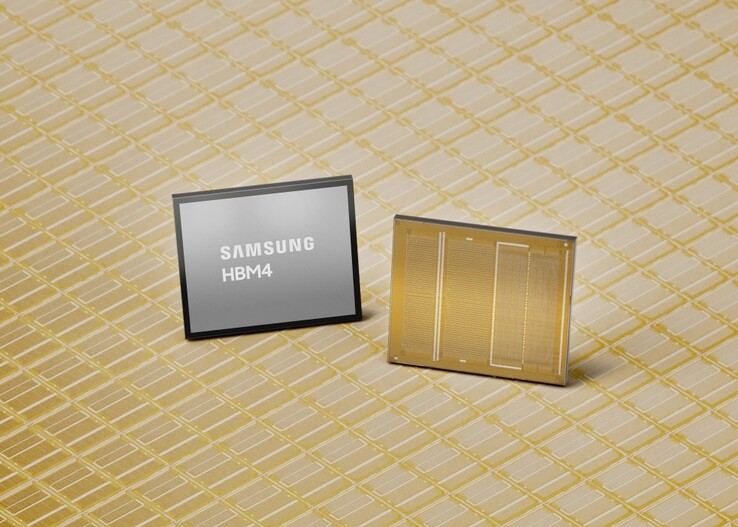

Samsung har tillkännagivit de första kommersiella leveranserna av ett HBM4-minne av nästa generation för applikationer som Nvidias GPU:er och respektive AI-datacenter.

Nvidia och andra kunder betalar enligt uppgift betalar nära 500 dollar per styck till Samsung, dubbelt så mycket som de brukade betala för den tidigare minnesgenerationen HBM3E med hög bandbredd. Som en följd av detta är Samsungs aktier rekordhöga, och ledningen förväntar sig ytterligare ett blockbusterår där man kan dra nytta av den allmänna minnesbristen minnesbrist.

Specifikationer för Samsungs HBM4-minne

Medan minnestillverkare för närvarande tar ut en arm och ett ben för varje enhet de producerar, säger Samsung att dess nya HBM4 AI-minne har lyckats överträffa både Joint Electron Device Engineering Council (JEDEC) -standarden och Nvidias krav.

HBM4:s drifthastighet kan nå hela 13 Gbps, eller 46% högre än JEDEC:s krav, och den totala minnesbandbredden är upp till 3,3 TB/s per stack, vilket vida överstiger de 3 TB/s som kunder som Nvidia kräver.

Samsung uppnådde denna halsbrytande genomströmning genom att i förväg tillämpa 10nm-klassen 6:e generationens 1c DRAM-process med basmatrisen tillverkad vid 4nm, i motsats till 14nm 1a DRAM som användes för HBM3 föregångaren. Detta ger HBM4 AI-minnesgenerationen gott om utrymme för process- och prestandaförbättringar. För att hantera all värme som genereras har Samsung designat kärnan och dataöverföringen med lågeffekt- och lågspänningsteknik för 30% bättre värmeavledning och 40% högre energieffektivitet jämfört med minnesgenerationen HBM3 som Nvidia nu använder i sina AI-grafikkort i Blackwell-serien.

För närvarande kan Samsung leverera maximalt 36 GB HBM4-minneskapacitet till kunder via en 12-lagers stack, men det kan också skapa 16-lagers stackning för totalt 48 GB när Nvidia är redo med respektive GPU-design och köpkraft. Samsung lovar att det räcker med de dyra HBM4-chipen och säger att de kommer att"fortsätta att säkra stabila leveransmöjligheter för att möta den växande efterfrågan på medellång till lång sikt, särskilt från AI och datacenter" när de börjar provta sitt nästa generations HBM4E-minne under andra halvan av 2026.

Köp 64 GB Crucial DDR5-minneskit för bärbara datorer på Amazon

Källa(n)

Topp 10...

» Topp 10: Bästa bärbara allround/multimediadatorerna

» Topp 10: Bästa bärbara speldatorerna

» Topp 10: Bärbara budget/kontorsdatorer

» Topp 10: Bästa bärbara kontors/premiumdatorerna

» Topp 10: Bärbara arbetsstationer

» Topp 10: De bästa små/kompakta bärbara datorerna

» Topp 10: Bästa ultrabooks

» Topp 10: Bästa hybriddatorerna

» Topp 10: Bästa surfplattorna

» Topp 10: Marknadens bästa smartphones