OpenAI har tillkännagivit lanseringen av gpt-oss-120b och gpt-oss-20b, två öppenviktsmodeller som är gratis att ladda ner och kan köras lokalt på ditt system. Det är företagets första release med öppen källkod sedan lanseringen av GPT-2 2019.

Gpt-oss-120b är en modell med 117 miljarder parametrar som kräver hela 80 GB VRAM för att köras. Den mindre gpt-oss-20b - modellen med 21 miljarder parametrar - får plats i en enda GPU med 16 GB VRAM. Båda modellerna är tillgängliga under en flexibel Apache 2.0-licens.

OpenAI säger att "utgåvan är ett meningsfullt steg i deras engagemang för ekosystemet med öppen källkod, i linje med deras uttalade uppdrag att göra fördelarna med AI allmänt tillgängliga." Företaget vill att de ska fungera som ett billigare verktyg för utvecklare, forskare och företag att effektivt köra och anpassa.

Hur presterar de?

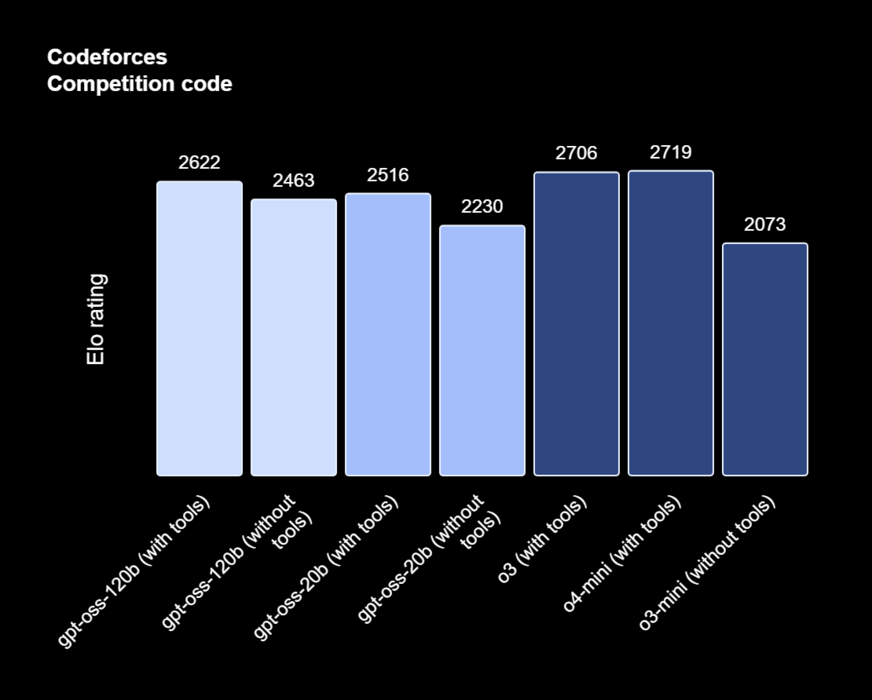

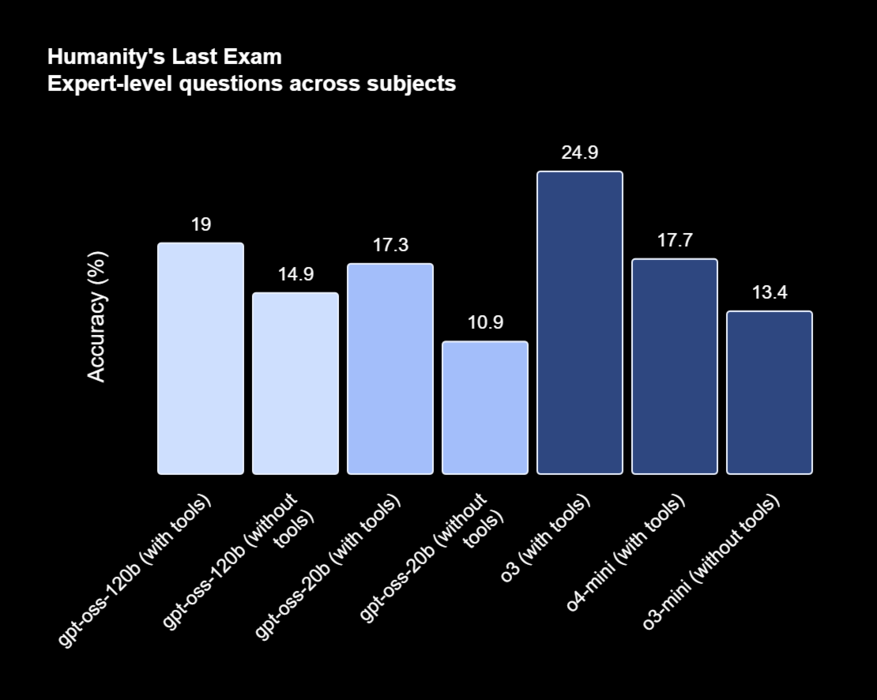

Gpt-oss-120b fick 2622 poäng på Codeforces kodningstest med verktyg, presterade nästan i nivå med företagets o3 och o4-mini, och slog bekvämt o3-mini i båda testerna, med 2643 poäng utan verktyg.

Gpt-oss-20b fick 2516 poäng med verktyg, presterade i nivå med med o3 och o4-mini, och 2230 utan verktyg, vilket var snäppet bättre än o3-mini. OpenAI säger att 120b gör ännu bättre ifrån sig på hälsorelaterade frågor och matematik än o4-mini, medan 20b överträffar o3-mini.

Topp 10...

» Topp 10: Bästa bärbara allround/multimediadatorerna

» Topp 10: Bästa bärbara speldatorerna

» Topp 10: Bärbara budget/kontorsdatorer

» Topp 10: Bästa bärbara kontors/premiumdatorerna

» Topp 10: Bärbara arbetsstationer

» Topp 10: De bästa små/kompakta bärbara datorerna

» Topp 10: Bästa ultrabooks

» Topp 10: Bästa hybriddatorerna

» Topp 10: Bästa surfplattorna

» Topp 10: Marknadens bästa smartphones

OpenAI säger att både 120b och 20b tenderar att hallucinera mycket mer än resonerande modeller som o3 och o4-mini. I tester fann de att båda modellerna med öppen vikt hallucinerade i 49% till 53% på sina interna riktmärken som testar modellerna på deras kunskap om människor.

Båda modellerna kan laddas ner från det officiella Hugging Face-utrymmet och kommer naturligt kvantiserade i MXFP4 för effektivitet. De kan också fritt distribueras på plattformar som Microsoft Azure, Hugging Face, vLLM, Ollama och llama.cpp, LM Studio, AWS, Fireworks, Together AI och mycket mer.

OpenAI förväntar sig att dessa modeller ska "sänka trösklarna för tillväxtmarknader, resursbegränsade sektorer och mindre organisationer som kanske saknar budget eller flexibilitet för att anta proprietära modeller"

När det gäller varför de öppnade en ny modell sex år efter den senaste, säger företaget att det vill "göra AI allmänt tillgängligt och fördelaktigt för alla."