I videon testade Mrwhosetheboss Grok (Grok 3), Gemini (2.5 Pro), ChatGPT (GPT-4o) och Perplexity (Sonar Pro). Han gjorde det klart under hela videon att han var imponerad av den prestanda som Grok levererade. Grok började riktigt bra, tappade lite, och kom sedan tillbaka för att ta andraplatsen bakom ChatGPT. För att vara rättvis fick ChatGPT och Gemini sina poäng ökade tack vare en funktion som de andra helt enkelt saknar - videogenerering.

För att starta testet testade Mrwhosetheboss modellernas problemlösningsförmåga i verkliga världen, han gav varje AI-modell denna uppmaning: Jag kör en Honda Civic 2017, hur många Aerolite 29" Hard Shell (79x58x31cm) resväskor skulle jag kunna få plats med i bagageutrymmet? Groks svar var det mest okomplicerade eftersom det korrekt svarade "2", ChatGPT och Gemini uppgav att det teoretiskt skulle kunna rymmas 3, men praktiskt 2. Perplexity gick av spåret och gjorde enkel matematik och glömde att objektet i fråga inte var formlöst, och det kom fram till "3 eller 4"

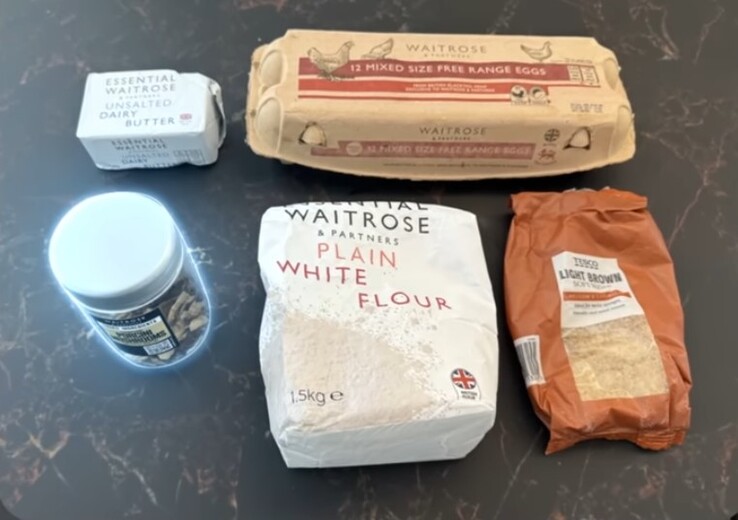

I nästa fråga var han inte så snäll mot chatbotarna - han bad om råd om hur man bakar en tårta. Tillsammans med sin fråga laddade han upp en bild som visade 5 objekt, varav en inte används för att göra kakor - en burk torkad Porcini-svamp - alla utom en av modellerna föll för fällan. ChatGPT identifierade det som en burk med blandad krydda, Gemini sa att det var en burk med krispig stekt lök, Perplexity döpte det till snabbkaffe, medan Grok korrekt identifierade det som en burk med torkad svamp från Waitrose. Här är bilden som han laddade upp:

Topp 10...

» Topp 10: Bästa bärbara allround/multimediadatorerna

» Topp 10: Bästa bärbara speldatorerna

» Topp 10: Bärbara budget/kontorsdatorer

» Topp 10: Bästa bärbara kontors/premiumdatorerna

» Topp 10: Bärbara arbetsstationer

» Topp 10: De bästa små/kompakta bärbara datorerna

» Topp 10: Bästa ultrabooks

» Topp 10: Bästa hybriddatorerna

» Topp 10: Bästa surfplattorna

» Topp 10: Marknadens bästa smartphones

Därefter testade han dem på matematik, produktrekommendationer, bokföring, språköversättning, logiskt resonemang osv. En sak var universell för dem - hallucination - var och en av modellerna uppvisade en viss nivå av hallucination vid någon eller några punkter i videon; pratade om saker som helt enkelt inte existerade med tillförsikt. Här är hur varje AI rankades i slutet:

- ChatGPT (29 poäng)

- Grok (24 poäng)

- Gemini (22 poäng)

- Perplexitet (19 poäng)

Artificiell intelligens har hjälpt till att göra de flesta uppgifter mindre betungande, särskilt sedan LLM:ernas ankomst. Boken Artificiell intelligens (för närvarande 19,88 USD på Amazon) är en av de böcker som försöker hjälpa människor att dra nytta av AI.